Wie funktionieren Webcrawler? Vollständiger technischer Leitfaden

Erfahren Sie, wie Webcrawler arbeiten – von Seed-URLs bis zur Indexierung. Verstehen Sie den technischen Ablauf, Crawler-Typen, robots.txt-Regeln und wie Crawle...

Crawler, auch bekannt als Spiders oder Bots, durchsuchen und indexieren das Internet systematisch, sodass Suchmaschinen Webseiten für relevante Suchanfragen verstehen und bewerten können.

Crawler, auch bekannt als Spiders oder Bots, sind ausgeklügelte automatisierte Softwareprogramme, die dazu entwickelt wurden, das riesige Internet systematisch zu durchsuchen und zu indexieren. Ihre Hauptfunktion besteht darin, Suchmaschinen dabei zu helfen, Webseiten zu verstehen, zu kategorisieren und anhand ihrer Relevanz und ihres Inhalts zu bewerten. Dieser Prozess ist entscheidend dafür, dass Suchmaschinen den Nutzern genaue Suchergebnisse liefern können. Indem sie Webseiten kontinuierlich scannen, bauen Crawler einen umfassenden Index auf, den Suchmaschinen wie Google nutzen, um präzise und relevante Suchergebnisse bereitzustellen.

Webcrawler sind im Wesentlichen die Augen und Ohren der Suchmaschinen. Sie ermöglichen es ihnen, den Inhalt jeder Webseite zu sehen, zu verstehen und zu entscheiden, wo sie im Index eingeordnet wird. Sie beginnen mit einer Liste bekannter URLs und arbeiten sich methodisch durch jede Seite, analysieren den Inhalt, identifizieren Links und fügen diese für zukünftige Crawls zu ihrer Warteschlange hinzu. Dieser iterative Prozess erlaubt es Crawlern, die Struktur des gesamten Webs zu kartieren – ähnlich wie ein digitaler Bibliothekar Bücher kategorisiert.

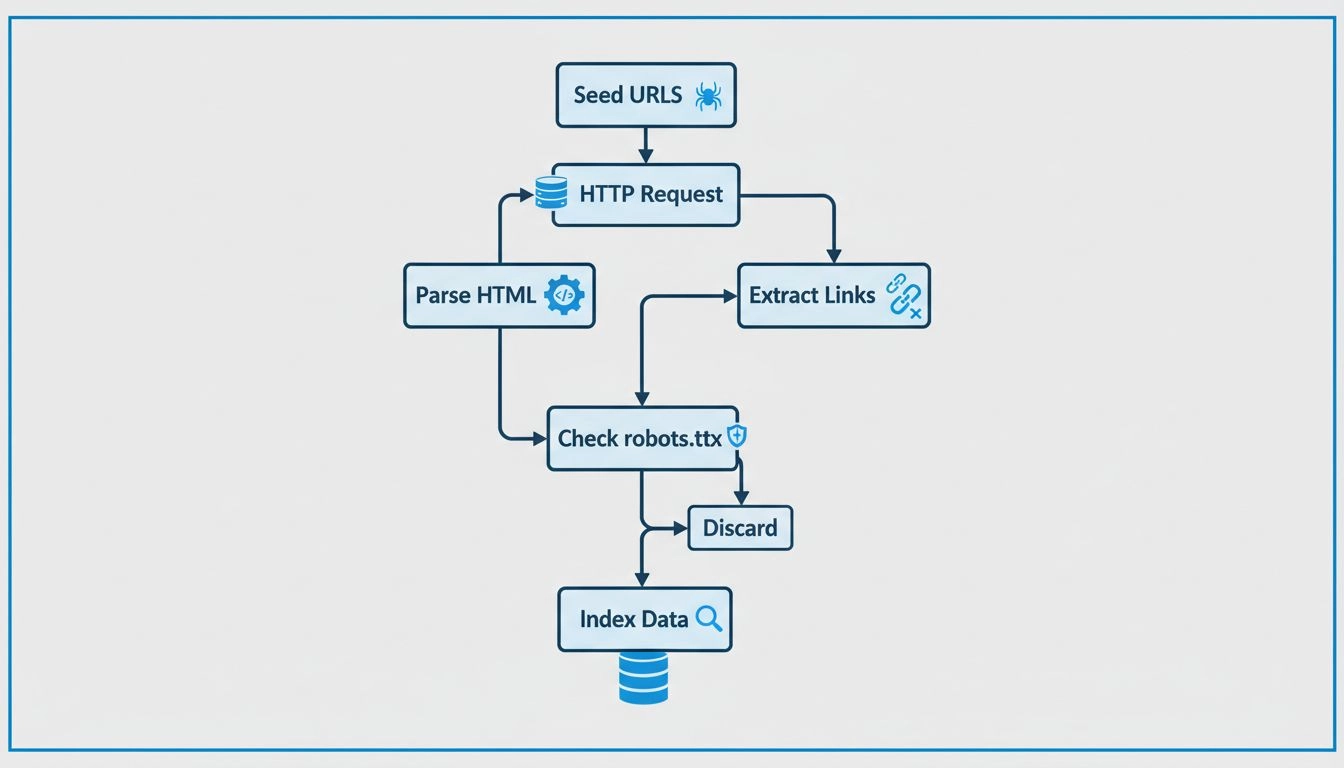

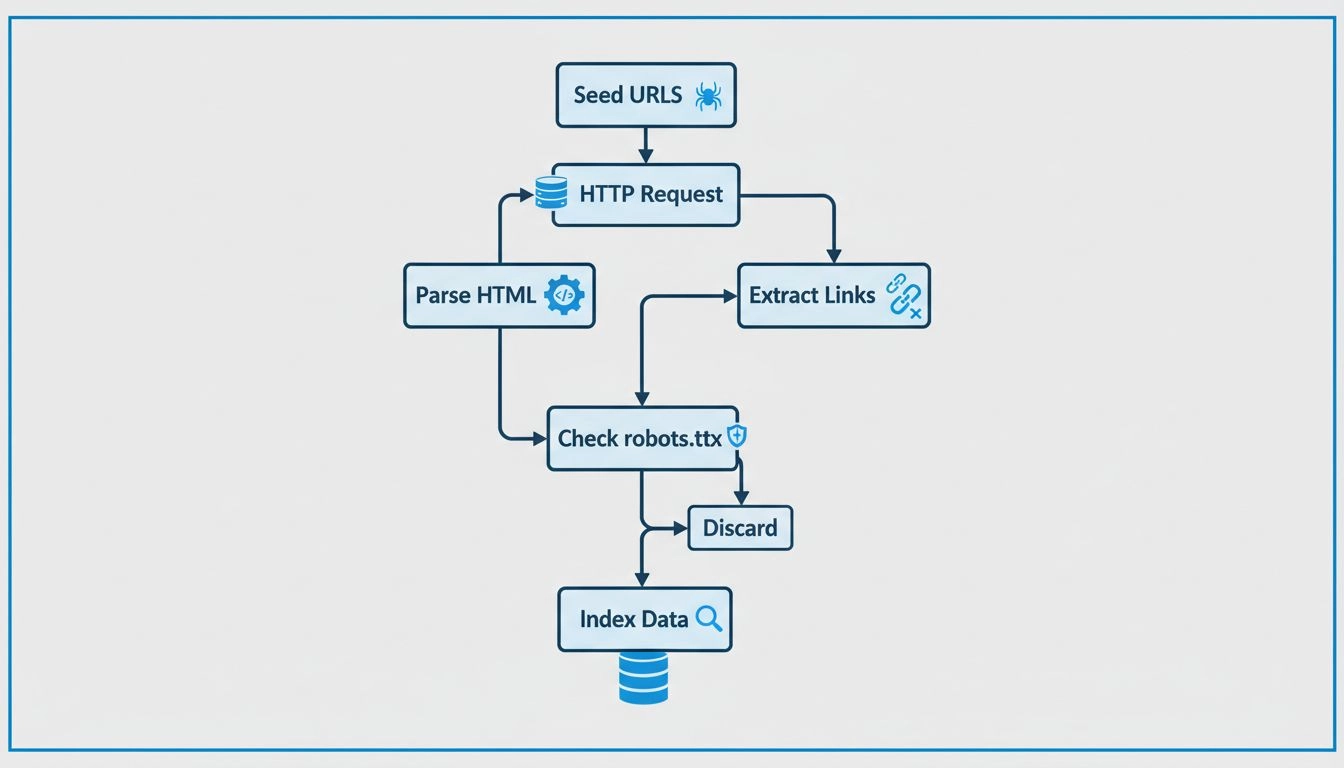

Crawler arbeiten, indem sie mit einer Ausgangsliste von URLs starten, die sie besuchen und überprüfen. Während sie diese Webseiten analysieren, identifizieren sie Links zu weiteren Seiten und fügen diese ihrer Warteschlange für den nächsten Crawl hinzu. Auf diese Weise kartieren sie die Struktur des Webs, indem sie Links von einer Seite zur nächsten folgen – vergleichbar mit einem digitalen Bibliothekar, der Bücher einordnet. Der Inhalt jeder Seite, einschließlich Text, Bildern und Metatags, wird analysiert und in einem riesigen Index gespeichert. Dieser Index bildet die Grundlage dafür, dass Suchmaschinen relevante Informationen als Antwort auf Nutzeranfragen bereitstellen können.

Webcrawler prüfen bei jedem Besuch die robots.txt-Datei einer Webseite. Diese Datei enthält Regeln, die angeben, welche Seiten gecrawlt werden dürfen und welche nicht. Nach dem Überprüfen dieser Regeln navigieren die Crawler gemäß vorgegebenen Richtlinien durch die Webseite, etwa nach der Anzahl der auf eine Seite verweisenden Links oder deren Autorität. Diese Richtlinien helfen dabei, die Reihenfolge der gecrawlten Seiten zu priorisieren, sodass wichtigere oder relevantere Seiten zügig indexiert werden.

Beim Crawlen speichern diese Bots den Inhalt und die Metadaten jeder Seite. Diese Informationen sind für Suchmaschinen entscheidend, um die Relevanz einer Seite für eine Suchanfrage zu bestimmen. Die gesammelten Daten werden anschließend indexiert, wodurch die Suchmaschine Seiten bei einer Suchanfrage schnell abrufen und bewerten kann.

Für Affiliate-Marketer , ist das Verständnis der Funktionsweise von Crawlern essenziell, um ihre Websites zu optimieren und das Suchmaschinen-Ranking zu verbessern. Effektive SEO beinhaltet die Strukturierung von Webinhalten so, dass sie für diese Bots leicht zugänglich und verständlich sind. Wichtige SEO-Maßnahmen sind:

Im Kontext des Affiliate-Marketings , haben Crawler eine differenzierte Rolle. Hier einige wichtige Aspekte:

Affiliate- Marketer können Tools wie die Google Search Console nutzen, um Einblicke zu erhalten, wie Crawler mit ihren Seiten interagieren. Diese Tools liefern Daten zu Crawl-Fehlern, Sitemap-Einreichungen und weiteren Metriken, sodass Marketer die Crawl-Fähigkeit und Indexierung ihrer Website verbessern können. Das Überwachen der Crawl-Aktivität hilft, Probleme zu erkennen, die die Indexierung beeinträchtigen könnten, sodass rechtzeitig Korrekturen vorgenommen werden können.

Indexierte Inhalte sind entscheidend für die Sichtbarkeit in den Suchergebnissen. Ohne Indexierung erscheint eine Webseite nicht in den Suchergebnissen – unabhängig von ihrer Relevanz für eine Suchanfrage. Für Affiliates , ist es unerlässlich, dass ihre Inhalte indexiert werden, um organischen Traffic und Konversionen zu erzielen. Eine korrekte Indexierung sorgt dafür, dass Inhalte gefunden und angemessen bewertet werden können.

Technisches SEO umfasst die Optimierung der Website-Infrastruktur, um effizientes Crawlen und Indexieren zu ermöglichen. Dazu gehören:

Strukturierte Daten: Die Implementierung strukturierter Daten hilft Crawlern, den Kontext von Inhalten zu verstehen und erhöht die Chancen, in erweiterten Suchergebnissen zu erscheinen. Strukturierte Daten liefern zusätzliche Informationen, die die Sichtbarkeit in Suchmaschinen verbessern können.

Seitenladegeschwindigkeit und Performance: Schnell ladende Seiten werden von Crawlern bevorzugt und tragen zu einer positiven Nutzererfahrung bei. Eine erhöhte Seitenladegeschwindigkeit kann zu besseren Rankings und mehr Traffic führen.

Fehlerfreie Seiten: Das Erkennen und Beheben von Crawl-Fehlern stellt sicher, dass alle wichtigen Seiten zugänglich und indexierbar sind. Regelmäßige Audits helfen, die Gesundheit der Website zu erhalten und die SEO-Leistung zu steigern.

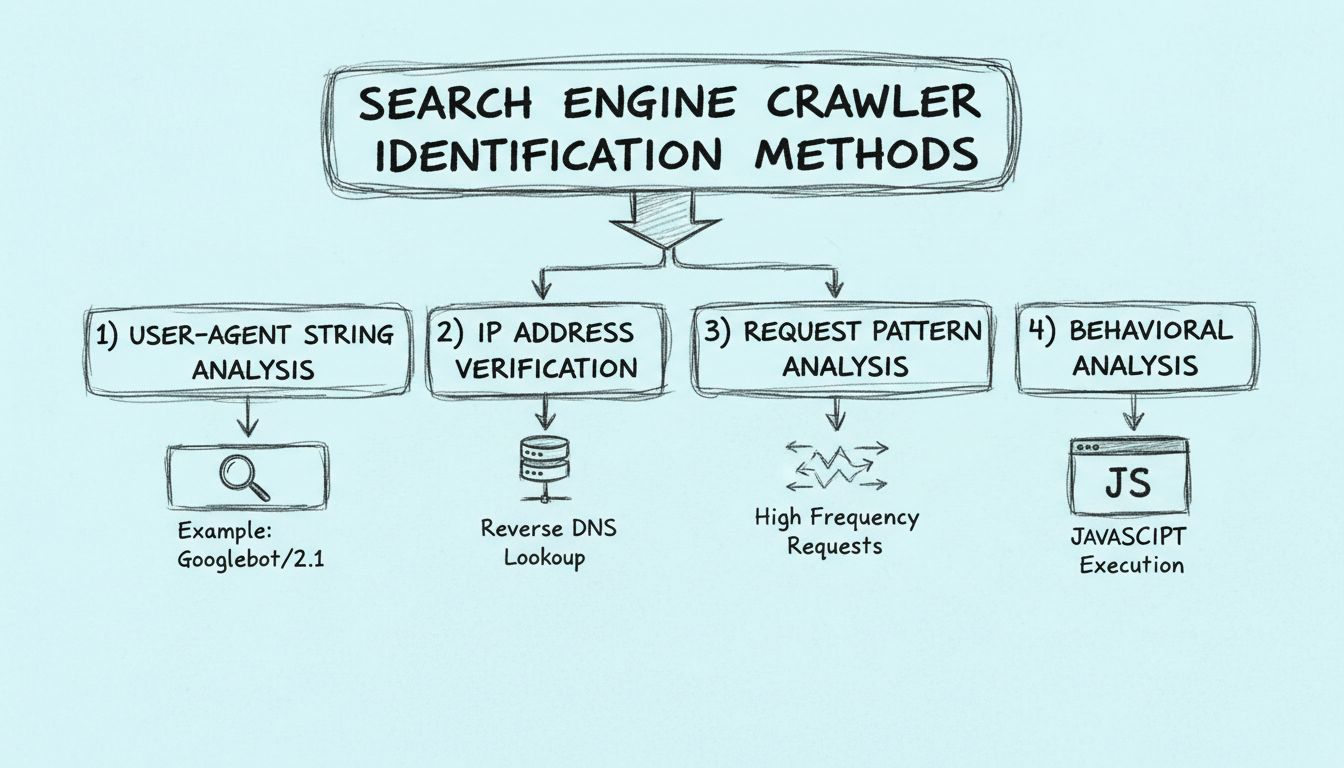

Suchmaschinen-Crawler können auf verschiedene Weise identifiziert werden, z. B. durch die Analyse des User-Agent-Strings des Crawlers, die Überprüfung der IP-Adresse des Crawlers und das Erkennen von Mustern in den Anfrage-Headern.

Webcrawler funktionieren, indem sie Anfragen an Websites senden und dann den Links auf diesen Websites zu anderen Websites folgen. Sie behalten den Überblick über die besuchten Seiten und die gefundenen Links, um das Internet zu indexieren und durchsuchbar zu machen.

Webcrawler werden Spiders genannt, weil sie das Netz durchkriechen, indem sie Links von einer Seite zur nächsten folgen.

Erfahren Sie, wie das Verständnis und die Optimierung für Crawler die Sichtbarkeit und das Ranking Ihrer Website in Suchmaschinen verbessern können.

Erfahren Sie, wie Webcrawler arbeiten – von Seed-URLs bis zur Indexierung. Verstehen Sie den technischen Ablauf, Crawler-Typen, robots.txt-Regeln und wie Crawle...

Erfahren Sie, wie Suchmaschinen-Crawler anhand von User-Agent-Strings, IP-Adressen, Anfrage-Mustern und Verhaltensanalysen erkannt werden können. Ein unverzicht...

Spiders sind Bots, die zum Spammen erstellt wurden und Ihrem Unternehmen viele Probleme bereiten können. Erfahren Sie mehr über sie im Artikel.

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.